1. Logstash 的基本原理

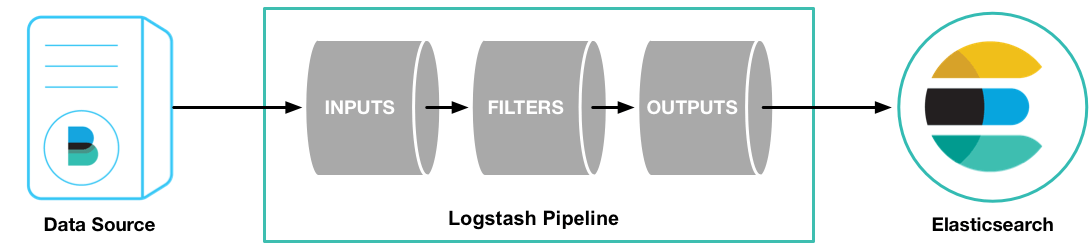

Logstash 是一个用于数据传输和处理的组件。

通过插件的组合,Logstash 可以满足各种日志采集的场景:

logstash->elasticsearch

filebeat->logstash->elasticsearch

filebeat->kafka->logstash->elasticsearch

filebeat->redis->logstash->elasticsearch

2. Logstash 的基本配置

下面是一个 Logstash 的配置格式:

| |

input 数据源包括:

azure_event_hubs、beats、cloudwatch、couchdb_changes、dead_letter_queue、elastic_agent、elasticsearch、exec、file、ganglia、gelf、generator、github、google_cloud_storage、google_pubsub、graphite、heartbeat、http、http_poller、imap、irc、java_generator、java_stdin、jdbc、jms、jmx、kafka、kinesis、log4j、lumberjack、meetup、pipe、puppet_facter、rabbitmq、redis、relp、rss、s3、s3-sns-sqs、salesforce、snmp、snmptrap、sqlite、sqs、stdin、stomp、syslog、tcp、twitter、udp、unix、varnishlog、websocket、wmi、xmpp。

参考:ES 输入插件

filter 过滤插件包括:

age、aggregate、alter、bytes、cidr、cipher、clone、csv、date、de_dot、dissect、dns、drop、elapsed、elasticsearch、environment、extractnumbers、fingerprint、geoip、grok、http、i18n、java_uuid、jdbc_static、jdbc_streaming、json、json_encode、kv、memcached、metricize、metrics、mutate、prune、range、ruby、sleep、split、syslog_pri、threats_classifier、throttle、tld、translate、truncate、urldecode、useragent、uuid、wurfl_device_detection、xml

参考:ES 过滤插件

output 输出源包括:

boundary、circonus、cloudwatch、csv、datadog、datadog_metrics、dynatrace、elastic_app_search、elastic_workplace_search、elasticsearch、email、exec、file、ganglia、gelf、google_bigquery、google_cloud_storage、google_pubsub、graphite、graphtastic、http、influxdb、irc、java_stdout、juggernaut、kafka、librato、loggly、lumberjack、metriccatcher、mongodb、nagios、nagios_nsca、opentsdb、pagerduty、pipe、rabbitmq、redis、redmine、riak、riemann、s3、sink、sns、solr_http、sqs、statsd、stdout、stomp、syslog、tcp、timber、udp、webhdfs、websocket、xmpp、zabbix

参考:ES 输出插件

在配置时,需要根据使用场景,结合官方文档进行调试。

3. Logstash 的配置示例

3.1 标准出入到标准输出

| |

3.2 文件到 ES

| |

3.3 Filebeats 到 ES

| |

3.4 Kafka 到 ES

| |